全球頂尖電腦製造商戴爾科技、慧與科技、聯想、美超微,以及雲端服務供應商 AWS、Google Cloud、Microsoft Azure、Oracle Cloud Infrastructure 皆開始提供搭載 H100 GPU 的產品,將於下個月開始供貨

NVIDIA (輝達) 今天宣布 NVIDIA H100 Tensor 核心 GPU 已全面投入生產,全球科技合作夥伴計畫在十月推出第一批搭載具開創性的 NVIDIA Hopper™ 架構 GPU 的產品及服務。

今年四月正式亮相的 H100 擁有 800 億個電晶體,受益於強大的全新 Transformer 引擎和 NVIDIA NVLink® 互連技術等多項技術突破,能加速最龐大的人工智慧 (AI) 模型,像是先進的推薦系統和大型語言模型,以及推動對話式 AI 與藥物開發等領域的創新。

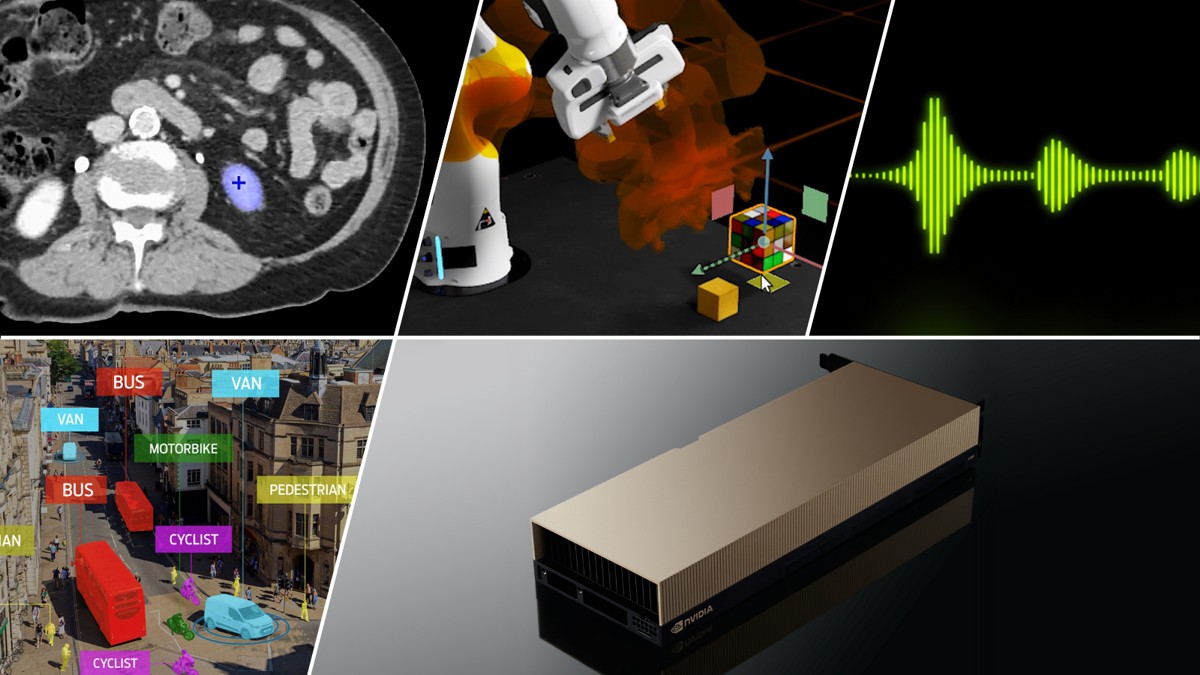

NVIDIA 創辦人暨執行長黃仁勳表示:「Hopper 是 AI 工廠的全新引擎,處理並精煉出海量數據,用以訓練具上兆個參數的模型,以推動語言 AI、機器人、醫療和生命科學領域的研究工作。Hopper 的 Transformer 引擎能以指數級提升運算效能,讓企業和研究人員能夠運用大規模的 AI 及高效能運算技術。」

除了 Hopper 架構與 Transformer 引擎外,第二代多執行個體 GPU、機密運算、第四代 NVIDIA NVLink 和 DPX 指令等多項關鍵創新技術亦是 H100 GPU 效能的關鍵,使 NVIDIA 加速運算資料中心平台未來的效能得以突飛猛進。

如今主流伺服器中使用的 H100 提供五年使用授權的 NVIDIA AI Enterprise 軟體套件,能使開發及部署 AI 工作流程更容易上手,確保企業組織能獲得打造 AI 聊天機器人、推薦引擎、視覺 AI 等應用所需的 AI 框架和工具。

Hopper 在全球市場推出

H100 讓能源效率提高 3.5 倍、總持有成本降低 3 倍,而使用的伺服器節點數量較上一代產品減少 5 倍,既能減少企業部署 AI 所需的成本,又能提供相同水準的 AI 運算效能。

欲即刻體驗全新技術的客戶可以在 NVIDIA LaunchPad 體驗 Dell PowerEdge 伺服器上的 H100,NVIDIA LaunchPad 提供免費的實作實驗室,企業可從中體驗最新的硬體和 NVIDIA AI 軟體。

客戶亦可開始訂購 NVIDIA DGX™ H100 系統,該系統搭載 8 顆 H100 GPU,在 FP8 精度下可提供 32 petaflops 的 AI 運算效能。NVIDIA Base Command™ 與 NVIDIA AI Enterprise 軟體支援每一套 DGX 系統,無論是單一節點或 NVIDIA DGX SuperPOD™ 等環境皆能進行部署,支援開發大型語言模型及其他大規模作業負載的先進 AI 應用開發。

全球各大電腦製造商皆推出搭載 H100 的電腦系統,預計將在未來幾週內供貨,今年年底前將有超過五十款伺服器上市,2023 年上半年將再有數十款上市。系統製造商合作夥伴包括源訊 (Atos)、思科 (Cisco)、戴爾科技 (Dell Technologies)、富士通 (Fujitsu)、技嘉 (GIGABYTE)、慧與科技 (Hewlett Packard Enterprise)、聯想 (Lenovo) 及美超微 (Supermicro)。

此外,全球多個頂尖高等教育與研究機構的下一代超級電腦亦將採用 H100,包括西班牙巴塞隆納超級運算中心 (Barcelona Supercomputing Center)、洛斯阿拉莫斯國家實驗室 (Los Alamos National Lab)、瑞士國家超級運算中心 (CSCS)、德州先進電腦運算中心 (Texas Advanced Computing Center) 及筑波大學。

H100 飛上雲端

Amazon Web Services、Google Cloud、Microsoft Azure 及 Oracle Cloud Infrastructure,將自明年起率先在雲端部署基於 H100 的執行個體。

Azure AI 基礎設施總經理 Nidhi Chappell 表示:「我們期待在 Microsoft Azure 的最新 H100 GPU 上啟用新一代 AI 模型。隨著 Hopper 架構的進步及我們對 Azure AI 超級運算的投資,我們將能協助加速全球 AI 的發展。」

Oracle Cloud Infrastructure 產品管理部門副總裁 Karan Batta 表示:「藉由提供客戶最新款的 NVIDIA H100 GPU,我們幫助他們更快處理最複雜的機器學習和高效能運算作業負載。使用 NVIDIA 的新一代 H100 GPU,讓我們能處理公司內部繁雜的作業負載,並協助雙方的共同客戶在醫療、自動駕駛車、機器人和物聯網等領域有突破性的進展。」

NVIDIA 的軟體支援

H100 具備的先進 Transformer 引擎技術,讓企業能快速開發出精度更高的大型語言模型。隨著這些模型的規模不斷擴大,複雜度亦隨之提升,訓練時間可能長達數個月。

包括 NVIDIA NeMo Megatron、Microsoft DeepSpeed、Google JAX、PyTorch、TensorFlow 及 XLA 在內的部分全球主要的大型語言模型和深度學習框架,正在 H100 上進行最佳化調整以解決這些問題。這些框架搭配 Hopper 架構,將大幅提升 AI 的運算效能,有助於在數日或數小時內訓練大型語言模型。

敬請觀看創辦人暨執行長黃仁勳在 GTC 的主題演講,深入了解 NVIDIA Hopper 及 H100。免費報名 GTC 大會,與 NVIDIA 及業界領袖一同參與精彩議程。