更新AMD Instinct加速器發展藍圖揭示領先業界AI效能與記憶體功能的年度進程

全新AMD Instinct MI325X加速器預計在2024年第4季上市,將配備多達288 GB的HBM3E記憶體;全新AMD Instinct MI350系列加速器採用AMD CDNA 4架構,預計在2025年出貨,較前一代產品的AI推論效能將有35倍的巨幅提升

全新AMD Instinct MI325X加速器預計在2024年第4季上市,將配備多達288 GB的HBM3E記憶體;全新AMD Instinct MI350系列加速器採用AMD CDNA 4架構,預計在2025年出貨,較前一代產品的AI推論效能將有35倍的巨幅提升

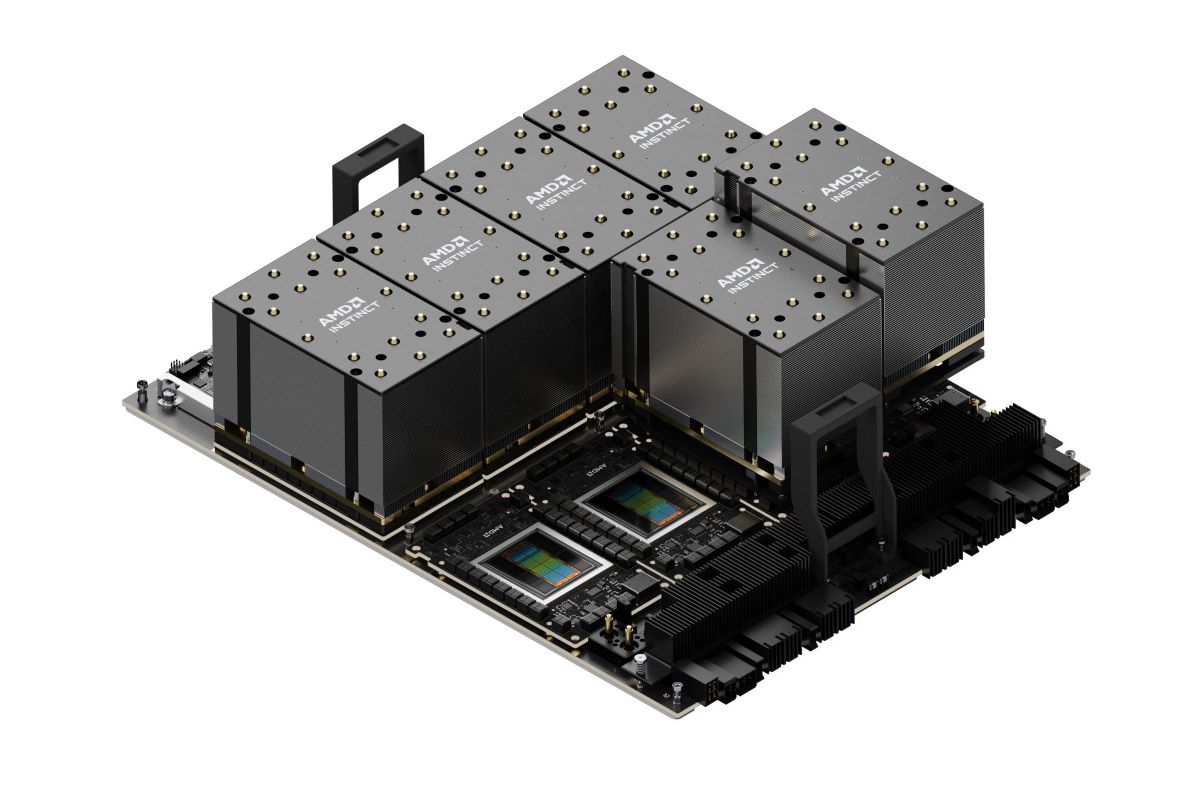

AMD(NASDAQ: AMD)董事長暨執行長蘇姿丰博士在COMPUTEX 2024開幕主題演講中,展現AMD Instinct™加速器系列的強勢發展動能。AMD揭示AMD Instinct加速器的跨年度產品藍圖,將逐年透過每個世代的AMD Instinct加速器挹注AI效能與記憶體功能優勢。

在更新版發展藍圖中,率先登場的是將於2024年第4季問市的全新AMD Instinct MI325X加速器。隨後則是AMD Instinct MI350系列,採用全新AMD CDNA™打造,預計在2025年上市,其AI推論效能將比AMD CDNA 3架構的AMD Instinct MI300系列大幅提升35倍註1。AMD Instinct MI400系列則將採用AMD CDNA “Next”架構,預定在2026年問市。

AMD資料中心加速運算全球副總裁Brad McCredie表示,AMD Instinct MI300X加速器持續受到Microsoft Azure、Meta、戴爾科技集團、HPE、聯想等眾多合作夥伴與客戶的熱烈採納,充分反映AMD Instinct MI300X加速器的卓越效能與價值。在更新版年度產品藍圖的引領下,我們努力不懈地推動創新,提供領先各界的功能與效能,迎合AI產業與客戶的期盼,促進資料中心AI訓練與推論的新一波革新。

AMD AI軟體產業體系日臻成熟

AMD ROCm™ 6開放軟體堆疊持續發展完備,助力AMD Instinct MI300X加速器為當今最熱門的大型語言模型(LLM)挹注卓越效能。在一部配備8個AMD Instinct MI300X加速器與ROCm 6軟體並運行Meta Llama-3 70B模型的伺服器,客戶可獲得相較競爭對手產品提升1.3倍的推論效能以及token生成吞吐量註2。而憑藉單一AMD Instinct MI300X加速器與ROCm 6軟體,在運行Mistral-7B模型時,客戶可獲得相較競爭對手產品提升1.2倍的推論效能以及token生成吞吐量註3。AMD亦披露最大型且最受歡迎的AI模型儲存庫Hugging Face目前每晚測試70萬個最熱門的模型,確保它們能在AMD Instinct MI300X加速器上直接運行。此外,AMD持續拓展與上游領域的合作,包括PyTorch、TensorFlow以及JAX等熱門AI框架。

AMD預覽新款加速器並公佈年度進程藍圖

AMD在主題演講中揭示AMD Instinct加速器藍圖的年度進程,因應各界對運行更多AI運算的爆發需求。這也將確保AMD Instinct加速器推動新一代前沿AI模型的開發。更新後AMD Instinct年度藍圖的重點包括:

全新AMD Instinct MI325X加速器將配備288 GB的HBM3E記憶體以及每秒6 terabytes的記憶體頻寬,沿用和AMD Instinct MI300系列相同的產業標準Universal Baseboard伺服器設計,預計將於2024年第4季問市。這款加速器將擁有領先業界的記憶體容量與頻寬,分別比對手高2倍與1.3倍註4,運算效能則是比對手高1.3倍註5。

AMD Instinct MI350系列中率先推出的是AMD Instinct MI350X加速器,採用AMD CDNA 4架構打造,預計在2025年上市。新品將沿用和MI300系列加速器相同的產業標準Universal Baseboard伺服器設計,採用先進3奈米製程技術,支援FP4與FP6 AI資料類型,並配備288 GB的HBM3E記憶體。

AMD CDNA “Next”架構將打造AMD Instinct MI400系列加速器,預計在2026年上市,將提供眾多最新特色與功能,協助為推論與大規模AI訓練挹注額外效能與效率。

AMD強調各界對AMD Instinct MI300X加速器的需求持續成長,眾多合作夥伴與客戶運用加速器運行其要求嚴苛的AI工作負載,其中包括:

- Microsoft Azure運用加速器運行Azure OpenAI服務以及新推出的Azure ND MI300X V5虛擬機器。

- 戴爾科技集團運用MI300X加速器打造Poweredge XE9680運行企業AI工作負載。

- 美超微(Supermicro)推出多款採用AMD Instinct加速器的解決方案。

- 聯想推出ThinkSystem SR685a V3為混合型AI創新挹注動能。

- HPE運用加速器打造HPE Cray XD675,加速AI工作負載。

歡迎至AMD官網瀏覽AMD在COMPUTEX發表的AI消息,以及前往AMD YouTube專頁觀看主題演講重播。

免責聲明

本新聞稿包含有關Advanced Micro Devices, Inc(AMD)的前瞻性陳述,包括AMD Instinct™加速器系列、AMD CDNA™ 4及AMD CDNA™ “Next” 等AMD產品的特色、功能、效能、上市時間、時程以及預期收益、產品藍圖、領先的AI效能、不斷增長的發展動能以及合作夥伴和客戶的需求。這些陳述皆基於1995年《私人證券訴訟改革法案》(U.S. Private Securities Litigation Reform Act)的「安全港」(Safe Harbor)條款所訂定出。這些前瞻性聲明含有像「將會」、「可能」、「預期」、「相信」、「計劃」、「打算」、「估計」,或這些字詞和短語的其它類似詞彙。投資者應注意本資料中的前瞻性陳述僅根據本文公布當時的見解、假設以及預期,僅反映本文發布時的情況,且涉及到許多風險與不確定因素,可能會導致實際結果與預期存在重大差異。這類陳述受到特定已知與未知風險與不確定因素所影響,其中許多因素難以預測且大多非AMD所能掌控,並可能響應實際結果與其他未來事件和文中陳述有所出入,或是和前瞻性陳述資訊與陳述的暗示或預期狀況有所不同。可能導致實際結果和當前預期有所出入的實質因素包括但不限於:包括Intel公司佔據微處理器市場,及其侵略性經營手段;半導體產業的周期性;AMD產品銷售行業的市場狀況;失去重要客戶;經濟局勢不確定性;AMD產品鎖定的市場競爭極為競爭;季度和季節性銷售模式;AMD充分保護其技術或其他知識產權的能力;不利的貨幣匯率波動;第三方廠商能及時製造足夠數量AMD的產品、或使用競爭對手的技術;基本設備、材料、載板或製造過程的可用性;達到AMD產品預期製造良率的能力;AMD能及時推出具有預期功能與效能水準的產品;AMD的半客製化SoC產品產生營收的能力;潛在的安全漏洞;潛在的安全事件,包括IT中斷、數據丟失、數據洩露和網路攻擊;有關AMD產品訂購和發貨的不確定性;AMD依賴第三方廠商知識產權來及時設計和推出新產品;AMD依賴第三方廠商來設計、製造和供應主機板、軟體、記憶體和其他電腦平台零組件;AMD依賴Microsoft和其他軟體供應商的支持來設計和開發可在AMD產品上運行的軟體;AMD依賴第三方分銷商和外接合作夥伴;修改或中斷AMD內部業務流程和資訊系統的影響;AMD產品與部分或全部行業標準軟體和硬體的兼容性;缺陷產品所產生的有關費用;AMD供應鏈的效率;AMD依靠第三方供應鏈物流功能的能力;AMD有效控制其產品在灰色市場上銷售的能力;氣候變遷對AMD業務的長期影響;政府行動和法規的影響,例如出口法規,關稅和貿易保護措施;AMD實現遞延所得稅資產的能力;潛在的稅收負債;當前和將來的索賠和訴訟;環境法律,與衝突礦物有關的規定以及其他法律或法規的影響;政府、投資者、客戶和其他利益關係人對企業責任事務不斷變化的期望;與負責任地使用AI相關的問題;;管理AMD票據的協議、賽靈思票據的保證和循環信用額度施加的限制;併購、合資與/或投資可能對業務產生的影響,以及整合收購事業的能力;合併公司資產之任何損耗可能產生的影響;政治,法律,經濟風險和自然災害;技術許可購買的未來減損;AMD吸引和留住人才的能力;AMD的股價波動。呼籲投資者詳閱公司呈交美國證管會各項財報中提及的風險與不確定因素,其中包括但不限於AMD最近的Form 10-K和10-Q報告。

註1:MI300-55:理效能預測於2024年5月31日進行,使用未來採用AMD CDNA 4的Instinct MI350系列加速器設計的工程估算,作為預計AMD CDNA™ 4效能。評估1.8T GPT MoE模型,假設即時token-to-token延遲為70毫秒,第一個token延遲= 5秒,輸入序列長度=8k,輸出序列長度=256,假設4x 8-mode MI350 series proxy (CDNA4)對比8x MI300X/GPU效能比較。實際效能將根據多種因素而有所不同,包括但不限於生產晶片的最終規格、系統配置以及所使用的推理模型和尺寸。

註2:MI300-54:測試於2024年5月28日由AMD效能實驗室進行,每個系統測試使用尺寸為1及2048個輸入token和128個輸出token生成Llama3-70B文本。

配置:

採用2P AMD EPYC 9534 64核心處理器的伺服器,搭載8個AMD Instinct™ MI300X (192GB, 750瓦) GPU,執行Ubuntu® 22.04.1和ROCm™ 6.1.1對比採用2P Intel Xeon Platinum 8468 48核心處理器的伺服器,搭載8個NVIDIA Hopper H100 (192GB, 750瓦) GPU,執行Ubuntu 22.04.3和CUDA® 12.2每個系統中使用了8個GPU進行測試。各家伺服器製造商配置各異,故測得結果亦可能不同。效能可能會根據使用最新驅動程式和最佳化方式而有差異。

註3:MI300-53:測試於2024年5月28日由AMD效能實驗室完成,使用Mistral-7B模型進行文本生成通量測試。測試使用尺寸為56,並對Mistral-7B使用2048個輸入token和2048個輸出token。

配置:

採用2P AMD EPYC 9534 64核心處理器的伺服器,搭載8個AMD Instinct™ MI300X (192GB, 750瓦) GPU,執行Ubuntu® 22.04.1和ROCm™ 6.1.1對比採用2P Intel Xeon Platinum 8468 48核心處理器的伺服器,搭載8個NVIDIA Hopper H100 (80GB, 700瓦) GPU,執行Ubuntu 22.04.3和CUDA® 12.2。

此測試僅使用了每個系統的1個GPU。各家伺服器製造商配置各異,故測得結果亦可能不同。效能可能會根據使用最新驅動程式和最佳化方式而有差異。

註4:MI300-48:測試於2024年5月22日由AMD效能實驗室進行的測試基於當前的規格和/或估算。預計AMD Instinct™ MI325X OAM加速器將具有288GB HBM3e記憶體容量和6 TFLOPS的峰值理論記憶體頻寬效能。基於生產晶片的實際結果可能有所差異。

NVIDIA Hopper H200 (141GB) SXM GPU加速器的已公佈的最佳結果顯示141GB的HBM3e記憶體容量和4.8 TB/s的GPU記憶體頻寬效能。

NVIDIA Blackwell HGX B100(192GB,700瓦)GPU加速器公布的最佳結果顯示192GB的HBM3e記憶體容量和8 TB/s的GPU記憶體頻寬效能。

NVIDIA Blackwell Architecture Technical Overview

NVIDIA Blackwell HGX B200(192GB)GPU加速器公布的最佳結果顯示192GB的HBM3e記憶體容量和8 TB/s的GPU記憶體頻寬效能。

NVIDIA Blackwell Architecture Technical Overview

註5:MI300-49: 測試於2024年5月28日由AMD效能實驗室進行的測試基於當前的規格和/或估算。AMD Instinct™ MI325X GPU的峰值理論半精度(FP16)效能為1307.4 TFLOPS,峰值理論Bfloat16格式精度(BF16)為1307.4 TFLOPS,峰值理論8位精度(FP8)為2614.9 TFLOPS,INT8浮點效能為2614.9 TOPs。實際效能可能根據最終規格和系統配置而有所差異。預計AMD Instinct™ MI325X OAM加速器將具有288GB HBM3e記憶體容量和6 TFLOPS的峰值理論記憶體頻寬效能。基於生產晶片的實際結果可能有所差異。

NVIDIA H200 SXM(141GB) GPU的已公布結果為:峰值理論半精度tensor(FP16 Tensor)效能為989.4 TFLOPS,峰值理論Bfloat16 tensor格式精度(BF16 Tensor)為989.4 TFLOPS,峰值理論8位精度(FP8)為1,978.9 TFLOPS,峰值理論INT8浮點效能為1,978.9 TOPs。NVIDIA使用稀疏度發布了BFLOAT16 Tensor Core、FP16 Tensor Core、FP8 Tensor Core和INT8 Tensor Core的效能;為了進行比較,AMD將這些數字轉換為非稀疏/密集,以上數字為除以2轉換後的結果。

NVIDIA H200資源:hpc-datasheet-sc23-h200-datasheet-3002446.pdf and NVIDIA at SC23: H200 Accelerator with HBM3e and Jupiter Supercomputer for 2024

NVIDIA H200 GPU具有與H100產品相同的FLOPs效能:NVIDIA H100 Tensor Core GPU Architecture Overview