NVIDIA 延續在 MLPerf 基準測試的領先優勢,A100 提供較 CPU

快237倍的 AI 推論速度,使企業能夠將 AI 技術從研究投入實際生產

快237倍的 AI 推論速度,使企業能夠將 AI 技術從研究投入實際生產

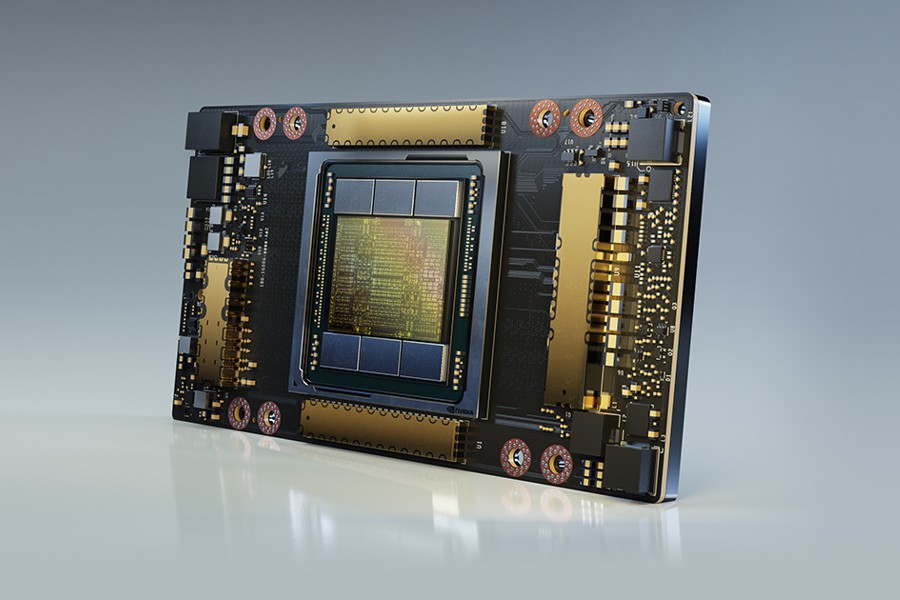

NVIDIA (輝達) 今日宣佈旗下的人工智慧 (AI) 運算平台,再度於最新的 MLPerf 效能基準測試中刷新效能紀錄,延續其在業界唯一衡量硬體、軟體與服務的 AI 效能之獨立基準的領先優勢。

在第二版的 MLPerf Inference 基準測試中,NVIDIA 在資料中心和邊緣運算系統的六項應用領域中的每一項測試均奪下冠軍。這次在既有的兩項電腦視覺測試外,又另外加入四個測試項目,含括發展最快的 AI 領域 ── 推薦系統、自然語言理解、語音辨識及醫療影像。

多個產業的組織早已運用 NVIDIA® A100 Tensor Core GPU 的卓越推論效能,將 AI 從研究單位帶入日常營運內。金融機構使用對話式 AI 以更快速地回答客戶的問題;零售商運用 AI 維持貨架上的庫存;醫療服務供應商透過 AI 分析數百萬張醫療影像,以更準確地辨識疾病並幫助拯救生命。

NVIDIA 加速運算部門副總裁暨總經理 Ian Buck 表示:「我們正處於一個轉捩點,各行各業都想找出更好的辦法來應用 AI 技術,以提供新的服務和拓展業務。我們投入許多心力,在 MLPerf 基準測試取得佳績,進一步提升企業的 AI 效能以改善我們的生活。」

最新的 MLPerf 結果出爐之際,NVIDIA 涉足 AI 推論領域的範圍也急劇增長。五年前只有少數引領業界的高科技公司將 GPU 用於推論作業;如今,NVIDIA 的 AI 平台可透過各大雲端運算與資料中心基礎設施供應商取得,各行各業的公司都能使用 NVIDIA 的 AI 推論平台提升其業務營運的表現,並提供額外的服務。

此外,NVIDIA GPU 目前在公有雲環境中提供 AI 推論的能力也首度超越 CPU。NVIDIA GPU 上的雲端 AI 推論運算量約每兩年成長十倍。

NVIDIA 讓 AI 推論能力更上一層樓

NVIDIA 與其合作夥伴提交的 MLPerf 0.7 基準測試成績是透過 NVIDIA 的加速平台而得,其中包括 NVIDIA 的資料中心 GPU、邊緣 AI 加速器及 NVIDIA 優化軟體。

NVIDIA 在今年稍早推出搭載第三代 Tensor Cores 及多執行個體 GPU 技術的 NVIDIA A100,在 ResNet-50 測試擴大了其領先優勢。在最新一次的測試中,A100 以 30 倍的優勢擊敗了 CPU 系統,而在上一輪的測試成果中則為六倍。根據 MLPerf Inference 0.7 基準測試,A100 在新加入的資料中心推論推薦系統測試中,較最新的 CPU 效能高出237倍。

這代表一台 NVIDIA DGX A100TM 系統就能提供約 1,000台雙插槽 CPU 伺服器一樣的效能,這讓客戶在將他們的 AI 推薦系統模型從研究投入生產時,提供極高的成本效益。

此基準測試亦顯示,NVIDIA T4 Tensor Core GPU 對於主流企業、邊緣伺服器和高成本效益雲端執行個體而言,依然是可靠的推論平台。在同樣的測試中,NVIDIA T4 GPU 的表現比 CPU 高出28倍。此外,NVIDIA Jetson AGX XavierTM 是系統單晶片邊緣設備中效能的佼佼者。

要有高度優化的軟體堆疊才能達到如此優異的效能表現,包括 NVIDIA TensorRTTM 推論優化器與 NVIDIA Triton 推論服務軟體,這兩個軟體都可以在 NVIDIA 的軟體目錄 NGC 中取得。

除了 NVIDIA 自己提交的成果,NVIDIA 的 11 個合作夥伴也使用 NVIDIA GPU 提交共 1,029 項成果,佔資料中心與邊緣類別提交總數的 85% 以上。